-

处理器

-

服务器

-

模组&卡

-

算法一体机

TPU处理器

RISC-V处理器

深度学习视觉处理器

-

-

-

-

-

微服务器SE7 32-EA4-23

微服务器SE7 32-EA4-23BM1684X,32路高清视频智能解析

-

智算卡

-

-

智算卡SC11 FP300

智算卡SC11 FP300256路视频解码,128路视频编码

智算模组

-

模组开发者套件 SM7 32-EN4-22-S

模组开发者套件 SM7 32-EN4-22-S32路高清硬解码与智能分析

-

智算模组SM7 32-EP4-22

智算模组SM7 32-EP4-2232路高清硬解码与智能分析

-

AS222随心配算法一体机

AS222随心配算法一体机近50种算法畅享,持续更新服务满足合规分析、环境检测、智能预警等管理需求

-

-

-

AS311餐饮门店算法一体机

AS311餐饮门店算法一体机算法丰富,覆盖服务柜台、就餐区、周界环境等场景,提升运营收益等需求

-

AS411稿件审核算法一体机

AS411稿件审核算法一体机审核速度达500字/秒,一台一体机同时可并行分析5篇稿件

-

模组

-

板卡

-

开发者套件

-

算力整机

-

深度学习模组

深度学习模组SOM1684,搭载算能BM1684,支持16路高清视频分析

-

深度学习核心板

深度学习核心板Core-1684-JD4,搭载算能BM1684,支持16路高清视频分析

-

深度学习计算模组

深度学习计算模组SBC-6841,搭载算能BM1684,支持16路高清视频分析

-

深度学习核心板

深度学习核心板iCore-1684XQ,搭载算能BM1684X,支持32路高清视频分析

-

深度学习核心板

深度学习核心板Core-1684XJD4,搭载算能BM1684X,支持32路高清视频分析

-

开源硬件开发板

开源硬件开发板Shaolin PI SLKY01,搭载算能BM1684,支持16路高清视频分析

-

深度学习模组

深度学习模组QY-AIM16T-M,搭载算能BM1684,支持16路高清视频分析

-

深度学习模组

深度学习模组QY-AIM16T-M-G,搭载算能BM1684,支持16路高清视频分析

-

深度学习模组

深度学习模组QY-AIM16T-W,搭载算能BM1684,支持16路高清视频分析

-

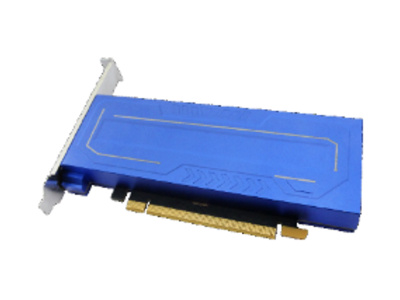

深度学习加速卡

深度学习加速卡AIV02T,PCIE板卡,1684*2,半高半长

-

深度学习工作站

深度学习工作站IVP03X,搭载算能BM1684X,支持32路高清视频分析

-

深度学习工作站

深度学习工作站IVP03A,微服务器 被动散热,12GB内存

-

边缘深度学习计算机

边缘深度学习计算机Coeus-3550T,搭载算能BM1684,支持16路高清视频分析

-

深度学习计算盒

深度学习计算盒EC-1684JD4,搭载算能BM1684,支持16路高清视频分析

-

深度学习1U集群服务器

深度学习1U集群服务器CSA1-N8S1684,算力集群服务器,BM1684*8,1U

-

电子封条分析装置

电子封条分析装置DZFT-ZDFX,ARM+DSP智能封条分析,搭载算能BM1684X

-

视频智能识别分析装置

视频智能识别分析装置ZNFX-32,搭载算能BM1684,支持16路高清视频分析

-

隔爆兼本安分析装置

隔爆兼本安分析装置ZNFX-8,ARM+DSP架构,隔爆兼本安分析装置符合煤安要求,搭载BM1684X

-

高算力深度学习主机

高算力深度学习主机EC-A1684JD4,微服务器主动散热,16GB内存,32GB eMMC

-

高算力深度学习主机

高算力深度学习主机EC-A1684JD4 FD,搭载算能BM1684,支持16路高清视频分析,16GB内存,32GB eMMC

-

高算力深度学习主机

高算力深度学习主机EC-A1684XJD4 FD,搭载算能BM1684X,支持32路高清视频分析

-

深度学习推理边缘计算盒

深度学习推理边缘计算盒ECE-S01,搭载算能BM1684,支持16路高清视频分析

-

禁限带物品智能分析设备

禁限带物品智能分析设备IOEHM-AIRC01,微服务器,主动散热,搭载算能BM1684,支持16路高清视频分析

-

深度学习视频采集分析设备

深度学习视频采集分析设备IOEHM-VCAE01,搭载算能BM1684,支持16路高清视频分析

-

深度学习 1U集群服务器

深度学习 1U集群服务器CSA1-N8S1684X,算力集群服务器,BM1684X*8,1U

-

深度学习服务器

深度学习服务器QY-S1U-16,1U版本BM1684盒子

-

深度学习 1U集群服务器

深度学习 1U集群服务器QY-S1U-192,算力集群服务器,BM1684*12,1U

-

深度学习 1U集群服务器

深度学习 1U集群服务器QY-S1X-384,算力集群服务器,BM1684X*12,1U

-

智慧政务

-

智慧交通

-

智慧公安

-

大物业

-

智慧商业

-

智慧生产

-

能源化工

-

智算中心

-

训推一体化

-

高速公路视频联网与智慧监测

视频实时压缩转码上云和监测异常事件,增强道路运行安全事件的发现和处置能力

-

车辆大数据

为交通拥堵、行车安全、车辆违法和道路污染治理问题赋能

-

全目标视频结构化

以国产化算力支撑海量视频的结构化解析,服务警务应用实战

-

步态大数据

以数据为中心打造“智能、协同、高效、创新”的步态识别大数据分析系统

-

多维研判智算一体机解决方案

为用户快速构建融合人、车、通行等多维数据的业务能力

-

通用安全生产

对生产全过程、全方位实时感知与精细化监管,推进应急监测智能化,赋能风险识别预警

-

智慧仓储

为粮仓、棉仓等大型仓储园区的办公、质检、磅房、库区等区域提供了违规行为和异常事件的安全监控方案

-

烟草行业安全生产

全量场景感知预警,赋能烟草生产作业过程数智化

-

白酒酒厂安全生产风险监测预警

为白酒生产企业细化风险监测因素,建立智能感知与预警感知体系,提高企业安全生产管理水平

-

智算中心

以云边协同的新型算力基础设施赋能各类数字城市场景,为数字经济发展提供源动力

-

深度学习算法训推一体化

以自动化训练推理一体化平台为基础,助力算力/算法整合应用快速、高效工程化落地